Политолог Рар: Европа с инициативой переговоров с Россией бежит за уходящим поездом

«Все больше европейских политиков начинает понимать, что победы Украины на поле боя не случится, а значит, надо завершать конфликт и договариваться о мире. Европа сейчас намерена во что бы то ни стало поучаствовать в мирной дипломатии, ведь в противном случае договоренность будет достигнута без них. А им не хочется, чтобы судьбу системы безопасности решали только Россия и США», – отметил германский политолог Александр Рар.

Он указал, что на этом фоне происходит сразу несколько событий: лидеры Прибалтики, опасающиеся разлада внутри ЕС, «побежали за уходящим поездом»; Эммануэль Макрон активно заговорил о необходимости переговоров с Москвой, и его поддержала премьер Италии Джорджа Мелони; Фридрих Мерц исключил вступление Украины в Евросоюз к 2027 году и таким образом лишил Владимира Зеленского последнего козыря.

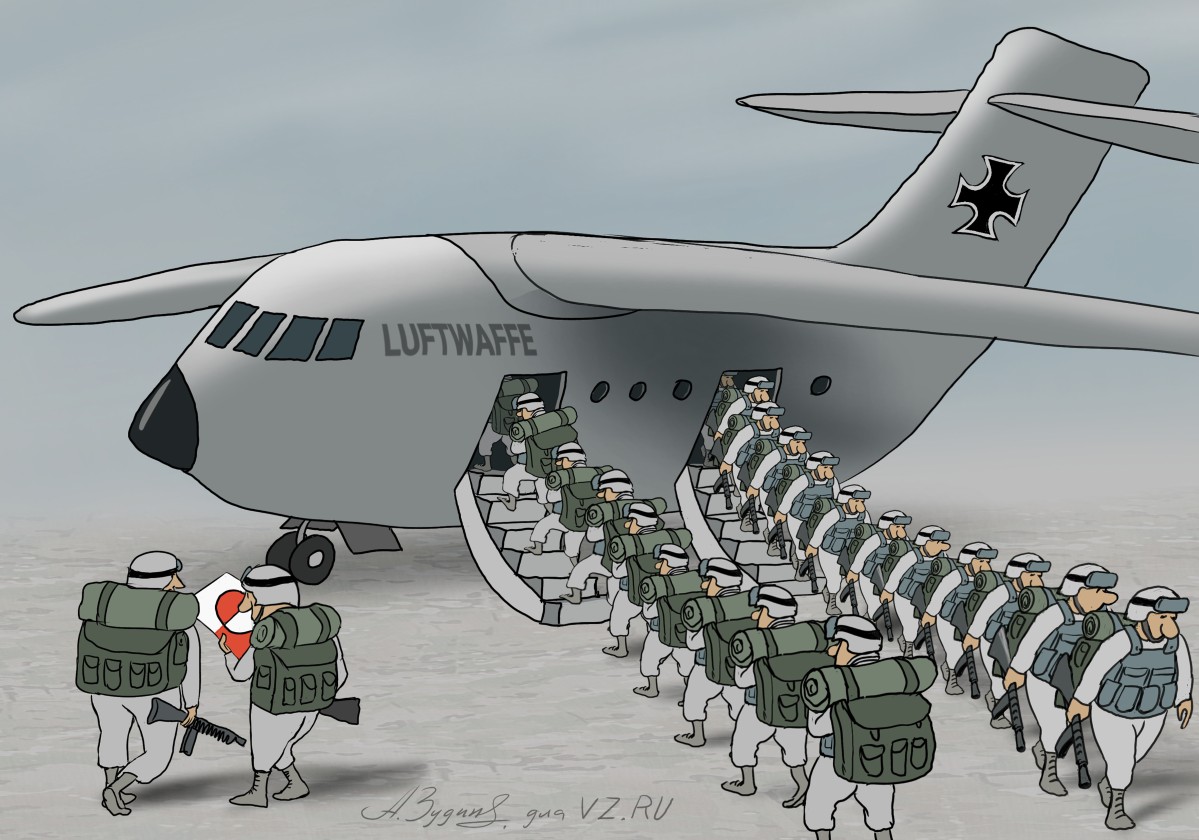

«Вместе с тем, Европа не хочет терять Украину. И Брюссель, и Вашингтон готовы вкладывать большие деньги в восстановление страны», – добавил собеседник. По мнению эксперта, европейцы на вероятных переговорах с Россией попытаются «побороться за свои интересы». «Их цель – сохранить присутствие НАТО или каких-то европейских военных структур хотя бы в западной Украине, в частности под Львовом. В этом кровно заинтересованы прибалты», – детализировал Рар.

Политолог отдельно обратил внимание на позицию Германии: «власти вместе с руководством Еврокомиссии по-прежнему выступают против контактов с Москвой, но при возможности выдвинут своего «кандидата» на переговоры, чтобы не оставить арену одному лишь Макрону». «Мерц будет соперничать с французским президентом за лидерство в дипломатии. Другое дело, что Берлин не хочет пока соглашаться с полной или частичной победой России, но понимание заканчивающихся сил на Украине преобладает», – пояснил аналитик.

По его прогнозам, европейцы, в том числе и немцы, постепенно начнут процесс «спасения собственного лица». «Идут споры между политиками о кандидатуре переговорщика: кто из них настолько важный, компетентный и еще не утерял полностью связей с Кремлем. Между тем, Дональд Трамп с удовольствием наблюдает за этими процессами со стороны», – сказал спикер. А Зеленский в этой поворотной политике остается проигравшим, добавил он.

«Как бы то ни было, позиция Москвы остается незыблемой: НАТО не может усиливать свое присутствие на границах РФ. Этот пункт будет главным на переговорах, и тут, как мне кажется, опять все зависит от американцев», – заключил Рар.

3 февраля в Москву приезжал дипломатический советник президента Франции Эммануэль Бонн. По информации источника Reuters, среди официальных лиц, с которыми виделся дипломат, был помощник президента России Юрий Ушаков. Целью встречи было налаживание диалога по ключевым вопросам, в том числе и по Украине.

Ранее Эммануэль Макрон сообщил, что ведется подготовка к «возможному обмену репликами» с российским президентом Владимиром Путиным. На этом фоне Рига и Таллин призвали к возобновлению диалога с Москвой. Премьер-министр Латвии Эвика Силиня и президент Эстонии Алар Карис поддержали идею назначить спецпосланника от Евросоюза для возобновления контактов с Россией. Об этом политики сообщили в интервью Euronews.

Карис отметил, что Европа запоздала с инициативой переговоров, уступив место за столом американскому президенту Дональду Трампу. Он подчеркнул, что, несмотря на это, европейская сторона сохраняет право быть услышанной, поскольку поддерживает Украину и косвенно участвует в конфликте.

«Пару лет назад мы были в позиции, что не разговариваем, а теперь переживаем, что нас нет [за столом переговоров]», — сказал эстонский лидер. Силиня также поддержала идею о переговорах, но заявила, что Европа по-прежнему должна оказывать давление на Россию. Она предложила на должность спецпосланника лидеров Германии, Франции или Британии.

В середине января издание Politico сообщало, что среди возможных кандидатов на эту роль рассматриваются кандидатуры президента Финляндии Александра Стубба и бывшего премьер-министра Италии Марио Драги. Официальный представитель российского МИД Мария Захарова отреагировала на заявление представителей Латвии и Эстонии. «Все та же идея про «место за столом». Понять можно: под столом сидеть надоело», – сказала она РИА «Новости».

Владимир Путин неоднократно подчеркивал, что Москва открыта к сотрудничеству со всеми странами без исключения. Министр иностранных дел Сергей Лавров, в свою очередь, отмечал, что заявления лидеров европейских стран о необходимости диалога с Россией звучат несерьезно. «Тем, кто хочет с нами разговаривать всерьез, я советую … если есть интерес серьезный, то надо просто позвонить, как у дипломатов принято, без всяких обвинений», – сказал он.

Газета ВЗГЛЯД разбиралась, зачем Европе, которая сама отказалась от мирных переговоров по Украине, понадобился свой спецпредставитель для контактов с Москвой и почему Стубб не годится на эту роль.

Игорь Мальцев

Ненависть Европы захлебнулась в желании говорить

Игорь Мальцев

Ненависть Европы захлебнулась в желании говорить