Более тысячи ученых, инженеров и бизнесменов со всего мира подписали письмо с призывом ввести запрет на использование автономных систем оружия, наделенных искусственным разумом. Среди них знаменитый британский теоретик и астрофизик Стивен Хокинг, американский изобретатель и бизнесмен Илон Маск, сооснователь Apple Стив Возняк, исполнительный директор Google DeepMind Демис Хассабис, лингвист Ноам Хомский.

Когда пилоту самолета или спецназовцу отдается приказ об уничтожении объекта, пилот и спецназовец тоже выступают в качестве интеллектуального оружия?

Письмо было обнародовано на проходящей в Буэнос-Айресе международной конференции по проблемам искусственного разума.

«Развитие технологии искусственного разума достигло стадии, когда подобные системы могут быть размещены на носителях в течение уже ближайших нескольких лет. Опасность велика, так как подобные автономные виды вооружений представляют собой третью революцию в военной области после изобретения пороха и ядерного оружия», – говорится в документе.

Авторы письма не призывают запретить в целом разработки технологий искусственного разума для оборонной промышленности, но, по их мнению, эти технологии не должны быть автономными и наделяться функцией самостоятельного принятия решений.

«Если ведущие военные державы продолжат разработки систем оружия с искусственным разумом, то мировая гонка вооружений станет неизбежной. Результат ее можно предсказать уже сейчас: автономное оружие станет таким же обыденным завтра, как автомат Калашникова сегодня», – подчеркивается в документе.

Автономная система, в отличие от автоматизированной, вообще не предполагает участия человека. До создания автономного оружия, по мнению экспертов, еще далеко. Тем не менее и на нынешнем уровне развития технологий ученые высказывают ряд опасений: команда на уничтожение человека на Ближнем Востоке может быть отдана офицером, находящимся в своем кабинете в США. И уровень осознания того, что он делает, у оператора БПЛА может весьма сильно отличаться от того, что есть у бойца, находящегося на передовой. Отдельной проблемой является возможное использование беспилотников без маркировки в интересах спецслужб.

Полностью исключить ошибку нельзя ни в автономной системе, ни в автоматизированной, однако в последнем случае по крайней мере можно найти того, кто отвечает за последствия ошибки.

«Разведывательно-ударные беспилотные системы являются автоматизированными системами. Вопрос идентификации целей, решение о применении оружия остаются за человеком, – сказал газете ВЗГЛЯД эксперт по беспилотным летательным аппаратам Денис Федутинов. – И можно найти конкретного человека, который принял то или иное решение. И в случае ошибки есть ответственный. Если мы переложим этот вопрос на автоматические системы, персоналий не будет. Я считаю, это совершенно преждевременно. По крайней мере в обозримой перспективе эти функции должны оставаться за человеком».

Он подчеркнул, что в развитии БПЛА сейчас происходит повышение доли автоматически или автоматизируемо реализуемых задач. «В настоящее время здесь речь идет об автоматизации этапов взлета-посадки, обнаружения целей, их идентификации и сопровождения. В перспективе также будут ставиться задачи автоматического поражения целей, при одиночных действиях и действиях в группе с другими пилотируемыми и беспилотными летательными аппаратами. Это должно продолжить сокращение времени цикла «обнаружение – поражение», повысив эффективность действий соответствующих систем. Между тем сейчас наблюдаются нередкие ошибки в идентификации целей, что нередко приводит к жертвам среди мирного населения. Подобные ошибки наверняка пусть и в меньшем объеме, но сохранятся в ближайшей перспективе», – сказал эксперт.

Как рассказал газете ВЗГЛЯД эксперт по робототехнике, советник общероссийской программы «Робототехника: инженерно-технические кадры России» Алексей Корнилов, вопрос о создании и применении такого оружия обсуждается не один год. «Но, на мой взгляд, проблема не в робототехнике», – сказал эксперт.

Корнилов отметил, что общепризнанного определения, что такое искусственный интеллект, на данный момент нет. Поэтому специалисты в разных областях договариваются и принимают соответствующие определения только для своих узких сфер.

Касаясь оружия с искусственным интеллектом, специалист пояснил, что «чаще всего под этим понимается некая система, которая может сама принимать решение об уничтожении или о причинении ущерба тому или иному объекту».

«Те системы, которые сейчас есть, не дотягивают (в интеллектуальном плане – прим. ВЗГЛЯД) даже до уровня насекомых, например пчелы, не говоря уже о собаке. Но если мы вспомним, что древние скифы, воюя с персами, сбрасывали на врага ульи с пчелами, или сейчас мы посылаем собаку за человеком, предполагая, что он преступник, хотя он может им и не быть, в этих случаях также используется интеллектуальное оружие?» – рассуждает он.

Другой пример: когда пилоту самолета или спецназовцу отдается приказ об уничтожении объекта, пилот и спецназовец тоже выступают в качестве интеллектуального оружия?

«Технически очень легко поставить на шасси орудие и сделать его телеуправляемым. И также мы можем наделить систему дополнительными функциями. Например, сделать ее не просто радиоуправляемой, а способной выполнять ряд самостоятельных действий – проехать из пункта А в пункт Б и прислать оператору по пути картинку того, что там происходит. И если он заметит нечто опасное, он прикажет системе открыть огонь. Следующим этапом мы могли бы наделить эту машинку и функциями поиска опасного объекта. Она скажет оператору: вот посмотри, в этом месте я видела какое-то движение, я предполагаю, что этот объект опасен и лучше его уничтожить. После чего оператор отдаст команду на уничтожение. Наконец, можно прописать для машины такой алгоритм действий, чтобы она сама, без оператора определяла потенциальную опасность и сама открывала огонь», – рассказал эксперт.

При этом он считает некорректным говорить о машинах и роботах как несущих угрозу людям. Как и в случае с собакой, ответственность несет человек, который отдает ей команду, на кого бросаться.

«Это не функция искусственного интеллекта... Так же можно сказать о турникете в метро, что он им обладает. Он же тоже должен «соображать», пропустить вас или нет, учитывая ряд обстоятельств, например внесли ли вы плату. И тут то же самое», – считает Корнилов.

Резюмируя, эксперт рассказал, что современное состояние науки технически позволяет сделать очень опасными самые разные вещи. При этом само по себе развитие технологий не создает человечеству проблем, а только может обострить те противоречия, какие уже есть. Винить технологии в чем-то глупо. Рассматриваемый вопрос «не технический».

Опасения, связанные с бесконтрольным развитием автономных систем, ученые высказывают регулярно. Два года назад спецдокладчик ООН по вопросу о внесудебных казнях, казнях без надлежащего судебного разбирательства или произвольных казнях Кристоф Хайнс призвал ввести повсеместный мораторий на производство летальных автономных роботизированных систем (Lethal autonomous robotics – LARS).

Эксперт рекомендовал призвать страны «ввести на национальном уровне мораторий на производство, сборку, передачу, приобретение, внедрение и использование LARS», пока применительно к этому виду вооружения не будут разработаны международные нормы. Использование подобных роботов у Хайнса «вызывает вопросы, имеющие далеко идущие последствия в том, что касается защиты жизни в условиях войны и мира».

Сейчас, подчеркнул спецдокладчик, таких правовых рамок не существует, поэтому не ясно, можно ли запрограммировать машины так, «что они будут действовать в соответствии с нормами международного гуманитарного права», особенно в том, что касается определения различий между военными и гражданскими лицами.

Помимо этого, заметил эксперт, «невозможно разработать сколько-нибудь адекватную систему правовой ответственности» при использовании автономных роботов. «В то время как в случае с беспилотными летательными аппаратами человек принимает решение, когда начать огонь на поражение, в LARS бортовой компьютер решает, в кого целиться», – сказал он.

В 2012 году правозащитная организация Human Rights Watch опубликовала 50-страничный доклад под названием «Теряя человечность: Аргументы против роботов», в котором предупредила об опасности создания полностью автоматизированного вооружения. Доклад, составленный Human Rights Watch совместно с Гарвардской школой права, призывал отдельные государства разработать международный договор, который бы полностью запретил производство и использование роботизированного вооружения.

Правозащитники отметили, что автономного боевого оружия пока не существует и до принятия его на вооружение еще далеко, однако военные в некоторых странах, к примеру в США, уже представили прототипы, которые воплощают значительный прорыв к созданию «машин-убийц».

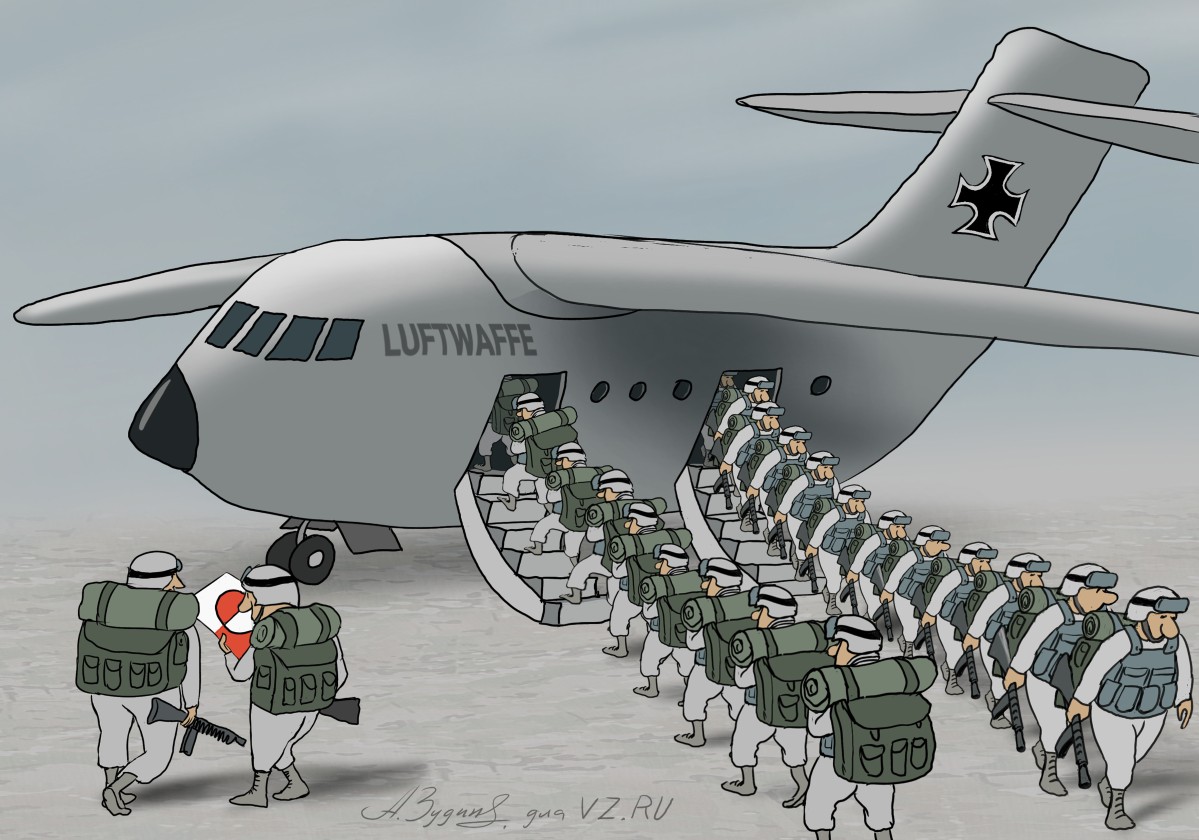

В докладе отмечается, что США лидируют в этой гонке, кроме того, в нее вовлечены некоторые другие страны, в том числе Китай, Германия, Израиль, Южная Корея, Россия и Великобритания.

По мнению многих специалистов, к полной автономии боевых машин странам придется идти от 20 до 30 лет.

Никита Анисимов

Для Кубы начался обратный отсчет

Никита Анисимов

Для Кубы начался обратный отсчет